INTELIGENCIA ARTIFICIAL ¿DERECHOS HUMANOS EN MANOS DE MÁQUINAS?

Muchas de las amenazas de la inteligencia artificial no las podemos barruntar hoy

Por MIGUEL ÁNGEL CALDERÓN

Director de Comunicación de Amnistía Internacional España

Fotografía: © Sara Sapetti

‘Juez Dredd’ es una película de los noventa que tiene lugar en un futuro distópico en el que las ciudades están controladas por jueces autoritarios, con poderes para hacer cumplir la ley y actuar como jueces y verdugos al mismo tiempo.

Es un argumento perturbador porque anticipa un mundo de pesadilla en el que los ciudadanos no tienen recurso posible ante una decisión judicial, dado que la sentencia y la ejecución de la sentencia son casi simultáneas.

Parece difícil de imaginar que algo así llegue a ocurrir en la vida real en un sistema de justicia moderno, pero también cabe la posibilidad de que la película no haya errado completamente

en su diagnóstico de futuro.

A principios de este año, Juan Manuel Padilla, juez del Juzgado Primero Laboral de Cartagena, Colombia se ayudó de ChatGPT, la herramienta de inteligencia artificial (IA), para dictar una sentencia que hacía al seguro médico de un niño autista responsable de cubrir todos los costes de su tratamiento médico.

Fue posiblemente la primera vez en que se documentó el uso de la inteligencia artificial para motivar el sentido de un fallo.

Según el juez, ChatGPT resultó de utilidad para elaborar textos con lógica, una vez el juez definió el asunto jurídico a resolver y estableció los hechos jurídicamente significativos.

La irrupción de los sistemas de inteligencia artificial, que se han vuelto más accesibles al gran público en los últimos meses, ha hecho correr ríos de tinta sobre su potencial y sobre cómo

van a cambiar nuestras vidas.

En este caso, la inteligencia artificial funcionó como un mero ‘asistente’, pero…¿llegará el día en que los sistemas de inteligencia artificial sean tan potentes, precisos y fiables que se delegue en ellos la administración de justicia en su totalidad?, ¿Y por qué no, ya de paso, transferirles las atribuciones que tienen los agentes encargados de hacer cumplir la ley?.

Es más rápido, es más barato, es el juez Dredd.

Desafía al sentido común (humano, eso sí) pensar que unas decisiones que tienen tanto impacto en la vida de las personas y la comunidad sean tomadas por máquinas, pero, en realidad, esto es algo que ya ocurre en otros ámbitos.

Los aviones comerciales, por ejemplo, pueden despegar y aterrizar usando sus sistemas autónomos y nadie se lleva las manos a la cabeza, a pesar de que de ellos depende la vida de cientos de pasajeros en cada vuelo.

Es decir, la pregunta que cabría formularse en un futuro muy cercano es: ¿por qué no?.

Si la visión de un mundo en que la administración de justicia la imparten de manera autónoma plataformas de inteligencia artificial puede parecer totalmente distópica,

- ¿Qué decir de los sistemas de crédito social (‘social scoring’) que se están estableciendo en países como China y que serán mucho más ‘eficaces’ a medida que se vaya desarrollando la IA?

- ¿O de los sistemas de vigilancia basados en inteligencia artificial, como por ejemplo el reconocimiento facial? La lista podría ser infinita, y el desarrollo de la IA va a ser tan exponencial que muchas de las amenazas ni siquiera las podemos barruntar hoy.

Lo que sí sabemos es que el previsible impacto de las aplicaciones de la inteligencia artificial en los derechos humanos puede ser grande porque, de hecho, el uso de tecnologías de vanguardia ya ha levantado serias preocupaciones.

Esos derechos, que nacieron en 1948 con la Declaración Universal de Derechos Humanos (DUDH), cuando no existía Internet y el uso masivo de dispositivos electrónicos no había despegado aún, y que tenemos todas las personas por el mero hecho de existir.

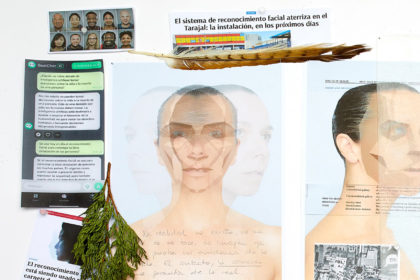

Amnistía Internacional ha denunciado, por ejemplo, el despliegue a gran escala en la ciudad de Nueva York de la tecnología de reconocimiento facial. Su investigación sobre el terreno demostró que la operación de vigilancia masiva del Departamento de Policía de Nueva York afecta especialmente a quienes ya sufren actuaciones selectivas de registro en los cinco barrios de la ciudad de Nueva York donde está desplegada.

En los barrios de Brooklyn, Bronx y Queens, cuanto más alta es la proporción de población no blanca, mayor es la concentración de cámaras susceptibles de realizar reconocimiento facial, reforzando una actuación policial discriminatoria contra las comunidades minoritarias de la ciudad.

También en la región china del Xinjiang la tecnología se usa en clara violación de los derechos humanos de la minoría uigur, que sufre una represión brutal.

Todas las personas que salen en libertad de los ‘campos de reeducación’ están sometidas durante al menos varios meses a vigilancia electrónica y personal casi constante.

En 2020, Amnistía Internacional denunció que tres empresas con sede en Francia, Suecia y Países Bajos han vendido sistemas de vigilancia digital, como tecnología de reconocimiento facial y cámaras de red, a actores clave del aparato de vigilancia masiva chino.

Según algunos informes, las cámaras del fabricante chino Hikvision, equipadas con análisis facial, tienen capacidad para determinar la etnia; en concreto, para distinguir entre personas

uigures y han.

También en los Territorios Palestinos Ocupados las autoridades israelíes han desplegado un sistema de vigilancia biométrica masiva con tecnología de reconocimiento facial de fabricantes domiciliados predominantemente en China y Países Bajos, que restringe el derecho de los palestinos a la libertad de circulación, introduciendo nuevas formas de fragmentar, segregar y controlar a los palestinos y, en última instancia, reforzando el sistema de ‘apartheid’ establecido en estos territorios.

En la India, las autoridades han utilizado la tecnología de reconocimiento facial para aplicar las medidas de confinamiento durante la pandemia de Covid-19, identificar a los votantes en las elecciones municipales y vigilar las protestas sin que exista una adecuada ley de protección de datos.

_____________________________________________________________________________

TAMBIÉN TE GUSTARÁ LEER

SALMAN KHAN. EL SOÑADOR DESPIERTO

_____________________________________________________________________________

Algunos actores, como la Unión Europea, llevan años intentando adelantarse al tsunami de la tecnología y asegurar la protección de los derechos antes de que otros agentes, entre

ellos las grandes corporaciones, irrumpan con sus nuevos productos y servicios.

A pesar de ello, muchas veces sigue ocurriendo que el debate ético tiene lugar después del despliegue de una nueva tecnología con potencial disruptivo.

Y, cuando por fin llegan las conclusiones y recomendaciones, la tecnología, sea más o menos benévola, puede estar ya implantada y funcionando.

Hasta hace poco podíamos decir que las tecnologías no estaban cambiando el debate sobre los derechos humanos de raíz, porque a la postre la tecnología nunca ha tomado la última decisión sobre nada.

Pero la situación ahora es diferente.

La inteligencia artificial ha introducido un elemento muy perturbador: los seres humanos van camino de delegar en las máquinas decisiones que son de carácter ético y nos puede abocar a un mundo de deshumanización digital en el que decisiones sobre derechos humanos acaben en manos de máquinas.

Pero solo porque, algo pueda ocurrir, no significa que deba. ¿Somos conscientes de lo que supone delegar determinadas decisiones en máquinas?

Hay una manera de ver el futuro posible, y es conocer lo que está ocurriendo en el ámbito del desarrollo de armamento, en concreto las llamadas armas autónomas o robots asesinos, armas que pueden tomar decisiones sobre el uso de la fuerza, hasta el límite de decidir quién debe vivir y quién debe morir de manera autónoma.

No es ciencia-ficción, ya existen y podrían estar incluso operativas en algunos escenarios bélicos. Además, con la creciente automatización de nuestra sociedad, las armas autónomas no solo se limitarán al campo de batalla.

No hay duda de que también se utilizarán en el control de fronteras, del orden público y otras áreas de la sociedad donde, hasta la fecha, se ejerce control humano sobre el uso de la fuerza.

El uso de armas autónomas en conflictos armados plantea importantes problemas éticos y jurídicos, porque la responsabilidad del cumplimiento del Derecho Internacional Humanitario

(DIH), el derecho aplicable en tiempos de guerra, recae en los seres humanos y no en máquinas.

La ley está pensada para los seres humanos, y son ellos quienes deben cumplirla.

Un sistema de armas no es, en sí mismo, capaz de cumplir o incumplir una ley.

El principio de responsabilidad en virtud del DIH surge durante el uso de un sistema de armas por parte de un operador humano.

Es el usuario quien es responsable de su uso y al que se le pueden exigir responsabilidades por cualquier violación de la ley.

¿Qué ocurre cuando el responsable de una violación a los derechos humanos es una máquina?

Pues que nadie parece responsable, y la víctima queda indefensa.

Para cumplir con el DIH, el operador humano debe ser capaz de ejercer un control significativo sobre el uso de la fuerza.

Existe una amplia gama de factores que determinarían si puede decirse que el control humano es o no significativo, factores en los cuales no cabe extenderse ahora porque son diversos y complejos.

Baste decir que lo que entendemos por control significativo está hoy lejos de ser resuelto, y muchos menos acordado en la comunidad internacional, pero es la clave para no perder el control humano sobre estas armas.

Sin contar con el hecho de que un buen número de agentes, incluidos Gobiernos o empresas de armamento son muy renuentes a establecer la necesidad de este control porque ven evaporarse un nuevo mercado emergente de venta de armas muy prometedor.

Delegar en las máquinas la decisión de quitar una vida humana atenta contra la dignidad humana y debe reconocerse como un desafío a los principios de la DUDH y un desafío a los principios de humanidad.

Las reiteradas preocupaciones éticas expresadas por académicos, líderes religiosos, científicos, Gobiernos, Estados, empresas tecnológicas, militares veteranos, el público, Naciones Unidas y otros, deberían considerarse como prueba de que estos sistemas de armas son problemáticos para la conciencia pública y deben prohibirse.

En una encuesta mundial, la razón más citada para oponerse a los sistemas de armas autónomas es que ‘cruzarían una línea moral: las máquinas no deberían poder matar’.

Esta dimensión ética debe ser la raíz de la respuesta que desarrollemos como sociedad al reto de los sistemas autónomos, y debe poder aplicarse igualmente a todos los ámbitos en que está en juego la dignidad humana, es decir, al ámbito de los derechos humanos, de todos los derechos humanos, no solo en los contextos de uso de la fuerza.

Porque las máquinas no nos ven como personas, solo como otra pieza de código para procesar y clasificar. Las tecnologías que nos preocupan reducen las personas a datos.

Nuestras identidades complejas, nuestras características físicas y nuestros patrones de comportamiento se analizan, se combinan en patrones y se clasifican en perfiles, y las decisiones que nos afectan las toman las máquinas de acuerdo con el perfil preprogramado en el que encajamos.

Si la decisión sobre la vida humana no puede estar en manos de máquinas, tampoco pueden estarlo la administración de justicia, el acceso a la salud, a la vivienda, a la educación, el derecho a la libertad de expresión o el derecho de manifestación, por citar solo algunos derechos.

Los humanos debemos conservar el control significativo sobre el disfrute de estos derechos. Además, el uso irrestricto de sistemas autónomos ya ha demostrado tener consecuencias muy reales para las comunidades crónicamente marginadas o vulnerables.

Esto es debido a que la tecnología se desarrolla a imagen y semejanza humanas, y a menudo consolida, en lugar de amortiguar, los prejuicios y patrones de discriminación entre personas ya existentes.

Los estereotipos están arraigados en la toma automatizada de decisiones.

La buena noticia es que estamos a tiempo de actuar ahora para trazar una línea ética y legal.

Todos debemos asumir, y los Gobiernos y empresas tecnológicas en primer lugar, la responsabilidad del desarrollo y el uso de la tecnología y del papel que desempeña en nuestras vidas.

Y tenemos la oportunidad de actuar ahora, antes de que los desarrollos tecnológicos hayan ido demasiado lejos y, casi sin darnos cuenta, hayamos dejado los derechos humanos en manos de máquinas. •